Inteligência artificial transforma atividade cerebral em fala

- Multiversolab7

- 12 de mai. de 2020

- 4 min de leitura

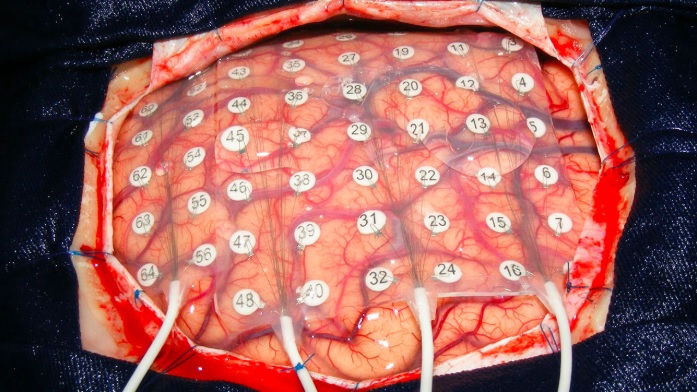

Pacientes com epilepsia com implantes de eletrodos têm ajudado os esforços para decifrar a fala.

Para muitas pessoas que estão paralisadas e incapazes de falar, os sinais do que eles gostariam de dizer se escondem em seus cérebros. Ninguém foi capaz de decifrar esses sinais diretamente. Porém, três equipes de pesquisa recentemente fizeram progressos na transformação de dados de eletrodos colocados cirurgicamente no cérebro em fala gerada por computador. Usando modelos computacionais conhecidos como redes neurais, eles reconstruíram palavras e frases que eram, em alguns casos, inteligíveis para os ouvintes humanos.

Nenhum dos esforços, descrito em artigos nos últimos meses no servidor de pré-impressão bioRxiv, conseguiu recriar um discurso que as pessoas apenas pensavam. Em vez disso, os pesquisadores monitoraram partes do cérebro enquanto as pessoas liam em voz alta, e em voz alta, ou ouviam gravações. Mas mostrar que o discurso reconstruído é compreensível é "definitivamente emocionante", diz Stephanie Martin, engenheira neural da Universidade de Genebra, na Suíça, que não esteve envolvida nos novos projetos.

As pessoas que perderam a capacidade de falar após um derrame ou doença podem usar os olhos ou fazer outros pequenos movimentos para controlar um cursor ou selecionar letras na tela. (O cosmólogo Stephen Hawking enrijeceu o rosto para acionar um interruptor montado nos óculos.) Mas se uma interface cérebro-computador pudesse recriar sua fala diretamente, eles poderiam recuperar muito mais: controle sobre o tom e a inflexão, por exemplo, ou a capacidade para interpor uma conversa em movimento rápido.

Os obstáculos são altos. "Estamos tentando descobrir o padrão de neurônios que ligam e desligam em diferentes momentos e inferem o som da fala", diz Nima Mesgarani, cientista da computação da Universidade de Columbia. "O mapeamento de um para o outro não é muito direto." Como esses sinais se traduzem em sons da fala varia de pessoa para pessoa, portanto os modelos de computador devem ser "treinados" em cada indivíduo. E os modelos se saem melhor com dados extremamente precisos, o que requer a abertura do crânio.

Os pesquisadores podem fazer essa gravação invasiva apenas em casos raros. Uma é durante a remoção de um tumor cerebral, quando as leituras elétricas do cérebro exposto ajudam os cirurgiões a localizar e evitar as principais áreas motoras e da fala. Outra é quando uma pessoa com epilepsia é implantada com eletrodos por vários dias para identificar a origem das crises antes do tratamento cirúrgico. "Temos, no máximo, 20 minutos, talvez 30", para coleta de dados, diz Martin. "Somos muito, muito limitados."

Os grupos por trás dos novos artigos aproveitaram ao máximo os dados preciosos, alimentando as informações em redes neurais, que processam padrões complexos passando informações através de camadas de "nós" computacionais. As redes aprendem ajustando as conexões entre os nós. Nos experimentos, as redes foram expostas a gravações de fala que uma pessoa produziu ou ouviu e dados sobre atividade cerebral simultânea.

A equipe de Mesgarani contou com dados de cinco pessoas com epilepsia. Sua rede analisou gravações do córtex auditivo (ativo durante a fala e a audição), enquanto esses pacientes ouviam gravações de histórias e pessoas nomeando dígitos de zero a nove. O computador reconstruiu os números falados apenas a partir de dados neurais; quando o computador "falou" os números, um grupo de ouvintes os nomeou com 75% de precisão.

Outra equipe, liderada pela cientista da computação Tanja Schultz, da Universidade de Bremen, na Alemanha, contou com dados de seis pessoas submetidas a cirurgia de tumor cerebral. Um microfone capturou suas vozes enquanto liam palavras de sílaba única em voz alta. Enquanto isso, eletrodos gravados das áreas de planejamento da fala e das áreas motoras do cérebro, que enviam comandos ao aparelho vocal para articular as palavras. Os cientistas da computação Miguel Angrick e Christian Herff, agora com a Universidade de Maastricht, treinaram uma rede que mapeou as leituras de eletrodos para as gravações de áudio e depois reconstruiu palavras a partir de dados cerebrais não vistos anteriormente. De acordo com um sistema de pontuação computadorizado, cerca de 40% das palavras geradas por computador eram compreensíveis.

Finalmente, o neurocirurgião Edward Chang e sua equipe da Universidade da Califórnia, em São Francisco, reconstruíram frases inteiras da atividade cerebral capturadas nas áreas da fala e motora, enquanto três pacientes com epilepsia liam em voz alta. Em um teste on-line, 166 pessoas ouviram uma das frases e tiveram que selecioná-la dentre 10 opções escritas. Algumas sentenças foram identificadas corretamente em mais de 80% das vezes. Os pesquisadores também aprimoraram o modelo: eles o usaram para recriar frases a partir de dados gravados enquanto as pessoas pronunciavam silenciosamente as palavras. Esse é um resultado importante, diz Herff - "um passo mais perto da prótese de fala que todos temos em mente".

No entanto, "o que realmente estamos esperando é como [esses métodos] farão quando os pacientes não puderem falar", diz Stephanie Riès, neurocientista da Universidade Estadual de San Diego, na Califórnia, que estuda produção de idiomas. O cérebro sinaliza quando uma pessoa silenciosamente "fala" ou "ouve" sua voz na cabeça, não são idênticas aos sinais de fala ou audição. Sem que o som externo corresponda à atividade cerebral, pode ser difícil para um computador decidir até onde a fala interna começa e termina.

A decodificação da fala imaginada exigirá "um grande salto", diz Gerwin Schalk, neuroengenheiro do Centro Nacional de Neurotecnologias Adaptativas do Departamento de Saúde do Estado de Nova York, em Albany. "Não está realmente claro como fazer isso."

Herff diz que uma abordagem pode ser dar feedback ao usuário da interface cérebro-computador: se eles puderem ouvir a interpretação da fala do computador em tempo real, poderão ajustar seus pensamentos para obter o resultado desejado. Com treinamento suficiente de usuários e redes neurais, cérebro e computador podem se encontrar no meio.

Fonte:https://www.sciencemag.org/news/2019/01/artificial-intelligence-turns-brain-activity-speech?utm_campaign=ScienceNow&utm_source=JHubbard&utm_medium=Facebook

Comentários